HarmonyOS 鸿蒙Next:降低大模型推理87%时延!华为云论文入选顶会USENIX ATC'24

HarmonyOS 鸿蒙Next:降低大模型推理87%时延!华为云论文入选顶会USENIX ATC’24

摘要:论文提出了CachedAttention,一种新的注意力机制允许在多轮对话中重用KV Cache,显著减少重复计算开销从而提升推理性能。

本文分享自华为云社区《降低大模型推理87%时延!华为云论文入选顶会USENIX ATC’24》,作者:华为云头条。

近日,计算机系统领域顶会USENIX ATC 2024在美国加州圣克拉拉召开,华为云EMS团队的论文《Cost-Efficient Large Language Model Serving for Multi-turn Conversations with CachedAttention》被该顶会收录!

CachedAttention论文提出全球首个面向大模型推理的多级KV Cache缓存系统,称作AttentionStore,基于AttentionStore实现了大模型推理过程中的KV Cache复用,降低了高达87%的首Token时延(TTFT, Time to First Token)。

USENIX ATC (Annual Technical Conference) 会议创办于1992年,距今有32年的历史,是由美国高等计算系统协会 (USENIX) 组织的聚焦计算机系统领域的顶级国际会议。2024年的USENIX ATC会议收到488篇投稿,录用77篇,录用率仅15.8%。

▶CachedAttention论文介绍

通过多轮对话与人类互动是大型语言模型(LLM)的一个基本特征。然而,现有的LLM服务引擎执行多轮对话时,需要反复计算历史Token的Key-Value (KV) Cache,从而导致效率低下,产生高昂的推理服务成本。

为了解决这个问题,本论文提出了CachedAttention,一种新的注意力机制允许在多轮对话中重用KV Cache,显著减少重复计算开销从而提升推理性能。

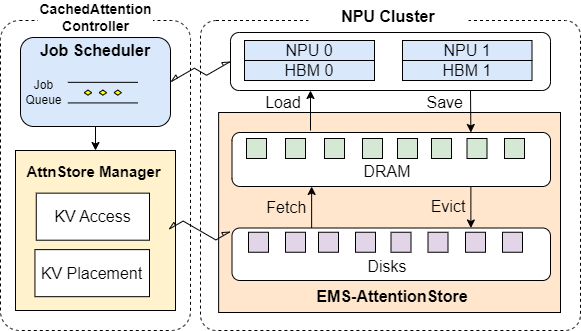

- CachedAttention维护一个分层的KV Cache存储系统(称作AttentionStore),利用经济高效的DRAM和SSD介质来保存请求的KV Cache。具体而言,为了减少从慢速介质上访问KV Cache的开销,CachedAttention采用了分层预加载和异步保存方法将KV Cache访问与NPU计算重叠。

- 其次,为了确保要访问的KV Cache总是放置在最快的存储层次,CachedAttention采用了一个调度程序感知的Fetch和Evict方法,有意识地根据推理作业调度程序的提示,在不同层中进行KV Cache的放置。

- 最后,为了避免由于LLM上下文窗口溢出而导致保存的KV Cache失效,CachedAttention通过解耦位置编码并有效截断KV Cache,使保存的KV Cache依然有效。

大量的实验结果表明,CachedAttention降低了高达87%的大模型推理的首Token时延 (TTFT) ,提升了Prefill阶段7.8倍的吞吐量,从而大幅降低端到端推理成本。

▲基于EMS-AttentionStore构建的CachedAttention系统架构图

CachedAttention论文信息:Bin Gao, Zhuomin He, Puru Sharma, Qingxuan Kang, Djordje Jevdjic, Junbo Deng, Xingkun Yang, Zhou Yu, Pengfei Zuo, “Cost-Efficient Large Language Model Serving for Multi-turn Conversations with CachedAttention”, in Proceedings of the 2024 USENIX Annual Technical Conference (USENIX ATC), 2024.

▶华为云AI-Native智算存储解决方案介绍

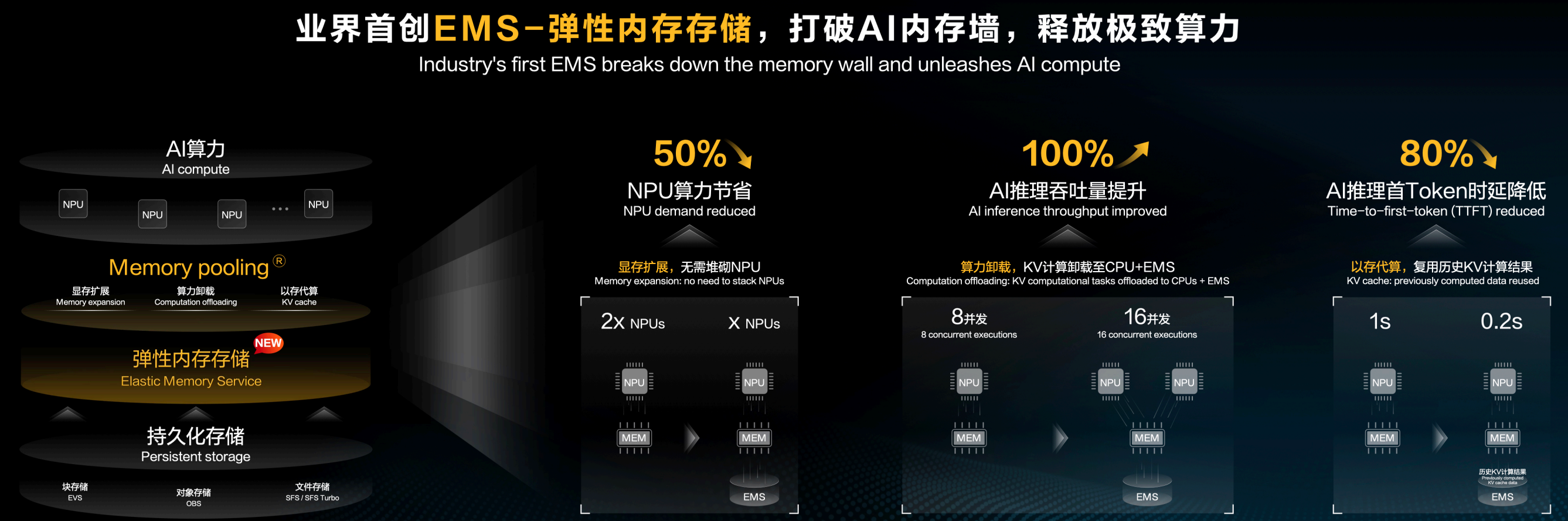

华为云EMS弹性内存存储服务是业界云厂商中首个在实际场景中得到使用的内存存储服务,通过Memory Pooling专利技术实现了“显存扩展”、“算力卸载”、“以存代算”三大功能来打破内存墙。

不仅如此,面向整个AI场景,华为云还形成了EMS弹性内存存储+SFS Turbo弹性文件存储+OBS对象存储的AI-Native智算存储解决方案,实现万亿模型存的下,训练任务恢复快,海量数据存的起,全面引领AI时代数据存储变革,帮助客户构建AI Native的基础设施。

▲HDC 2024上华为云发布EMS弹性内存存储服务

更多关于HarmonyOS 鸿蒙Next:降低大模型推理87%时延!华为云论文入选顶会USENIX ATC'24的实战系列教程也可以访问 https://www.itying.com/category-93-b0.html