Python中如何自己搭建人工智能算法平台并进行开源交流

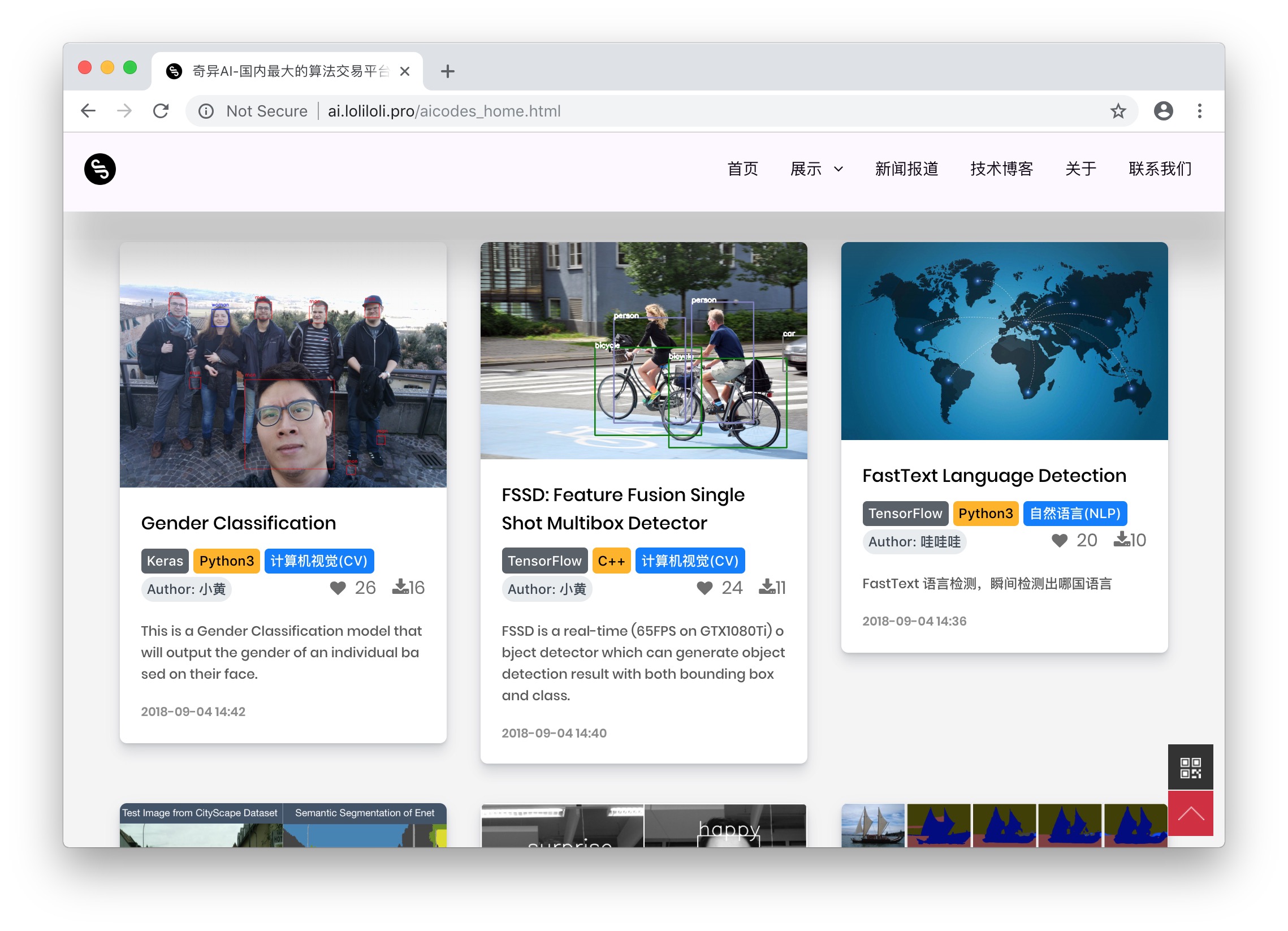

空余时间自己搭建了一个名为 StrangeAI 的 Paas 智能算法交易平台。看名称你应该知道我是个重症漫威痴迷者。

我自己提供了一些开元算法,涵盖从人工智能视觉、自然语言处理、到语音、自动驾驶、缺陷物体检测等 48 个领域、3000 多种开箱即用等算法模型。

我旨在打造国内首个人工智能算法 Paas 平台,利用自己的圈子,找了近 30 位一线工程师以及学术专家为平台贡献开源代码。所有算法均有效果显示、环境依赖、以及部署流程,并且你也可以训练自己的数据集!可以 Finetue !

我自己也建立了一个社群,期待有共同愿景的人能聚集在此交流探讨,共同进步。有意向的同僚,看这里:base64 — amludGlhbmlsb3ZldQ==

当然,直接搜索 “奇异人工智能” 也可以找到大本营,我和另外一百多人等你。

Python中如何自己搭建人工智能算法平台并进行开源交流

mark

这个问题挺有意思的,自己搭AI平台并开源交流,这事儿核心就两块:把东西做出来和把东西分享出去。

先说怎么“做出来”。这取决于你想做多“重”的平台。如果只是想有个地方跑跑模型、做做实验,那用Flask或FastAPI搭个简单的Web API服务是最快上手的。下面是个用FastAPI的极简例子,它暴露一个推理接口,并集成了模型版本管理的基础思路:

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

import joblib

import numpy as np

from typing import Optional

import os

# 假设我们有一个简单的模型版本管理目录

MODEL_DIR = "./model_versions"

os.makedirs(MODEL_DIR, exist_ok=True)

app = FastAPI(title="My Simple AI Platform API")

# 请求和响应的数据模型

class PredictionRequest(BaseModel):

features: list

model_version: Optional[str] = "latest" # 支持指定模型版本

class PredictionResponse(BaseModel):

prediction: float

model_version_used: str

def load_model(version: str):

"""加载指定版本的模型。'latest'则加载最新的。"""

if version == "latest":

# 简单实现:找目录下最新的.pkl文件

model_files = [f for f in os.listdir(MODEL_DIR) if f.endswith('.pkl')]

if not model_files:

raise FileNotFoundError("No model found.")

latest_model = sorted(model_files)[-1] # 按文件名排序取最新

version = latest_model.replace('.pkl', '')

model_path = os.path.join(MODEL_DIR, latest_model)

else:

model_path = os.path.join(MODEL_DIR, f"{version}.pkl")

if not os.path.exists(model_path):

raise FileNotFoundError(f"Model version {version} not found.")

return joblib.load(model_path), version

@app.post("/predict", response_model=PredictionResponse)

async def predict(request: PredictionRequest):

try:

model, version_loaded = load_model(request.model_version)

# 将特征列表转为numpy数组进行预测(这里假设是回归模型)

features_array = np.array(request.features).reshape(1, -1)

prediction = model.predict(features_array)[0]

return PredictionResponse(prediction=float(prediction), model_version_used=version_loaded)

except FileNotFoundError as e:

raise HTTPException(status_code=404, detail=str(e))

except Exception as e:

raise HTTPException(status_code=500, detail=f"Prediction failed: {str(e)}")

# 一个简单的模型列表接口,方便前端或用户查看

@app.get("/models")

async def list_models():

model_files = [f.replace('.pkl', '') for f in os.listdir(MODEL_DIR) if f.endswith('.pkl')]

return {"available_models": sorted(model_files)}

# 启动命令:uvicorn main:app --reload

这个代码提供了一个可运行的API服务,包含了模型加载、版本管理和错误处理。你可以在此基础上添加用户认证、数据预处理、更复杂的模型部署(比如用ONNX或TorchServe)、以及任务队列(用Celery)来支持异步训练。

再说“开源交流”。东西做出来之后,你得让人能用、能看懂、能一起改。关键就这几点:

- 扔GitHub上:这是标配。建个仓库,把代码、文档、示例数据都放上去。

README.md写得清楚点,说明这是干嘛的、怎么安装、怎么用。 - 写好文档:用Sphinx或MkDocs生成漂亮的文档,详细说明API接口、如何贡献代码、项目结构。别让人猜。

- 打好包:写个

setup.py或pyproject.toml,把你的平台打包成PyPI可以安装的库,这样别人一句pip install your-platform就能用。 - 社区运营:在GitHub Issues里积极回复问题,用Discord或Slack建个频道让大家讨论。定一些清晰的贡献指南(比如代码规范、怎么提PR),降低别人的参与门槛。

总结一下:先基于Web框架和模型服务把核心功能跑通,然后通过规范的GitHub项目、文档和打包来开放协作。

谢谢分享

很强,看不懂😂

为什么主域名是别的网站。。。 loli 这样的域名是不是不够严肃。。。

很不错,只是网站不太完善,期待完成后的样子

今天上午新的域名已通过备案,欢迎来逛。strangeai.pro

不断完善中,感谢关注。你也可以加入我们的社群,和大家一起成长。

感谢 的分享,希望自己可以学习进步

Mark

mark

谢谢分享~ 目前看起来有点儿像维护更良好一些的 gitxiv ?