HarmonyOS鸿蒙Next中封装JPEG图片为MP4文件有原生库吗?还是需要调用C语言代码

HarmonyOS鸿蒙Next中封装JPEG图片为MP4文件有原生库吗?还是需要调用C语言代码 【问题描述】:我们有很多JPEG图片,封装为mp4文件,做这个功能有原生鸿蒙库吗?还是需要调用c语言代码。

【问题现象】:jpeg图片是socket网络传输到手机app上的。需求是要将多个图片封装为MP4格式的文件。

【版本信息】:不涉及

【复现代码】:不涉及

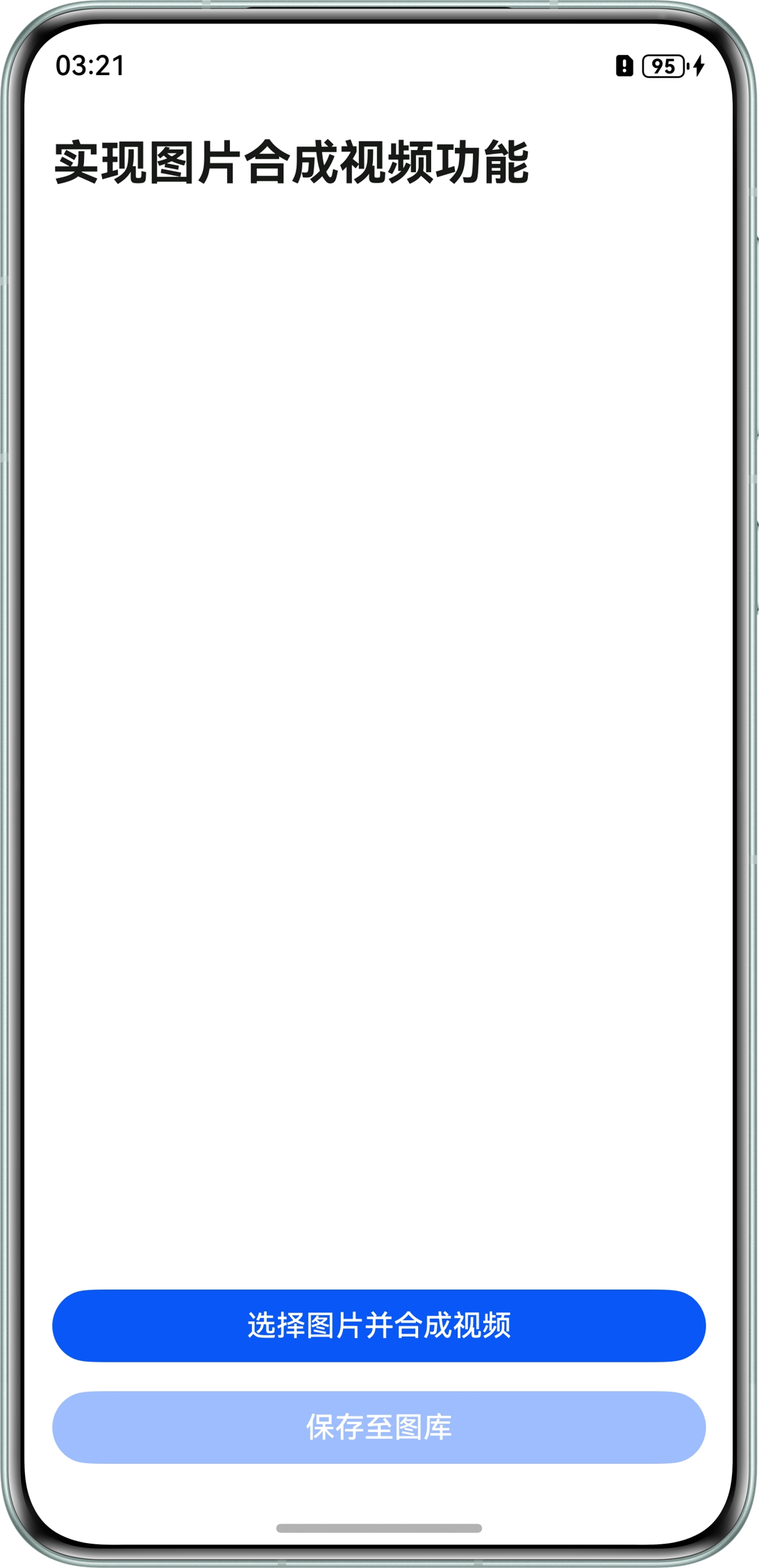

实现图片合成视频功能

项目简介

本示例基于AVCodec能力,实现了Buffer模式下的图片合成视频功能。通过ImageSource将图片解码为PixelMap对象,传递PixelMap到Native侧,然后调用Native侧的编码器和封装器,完成从图片解码、视频编码、封装的过程。

效果预览

使用说明

- 进入首页,点击"选择图片并合成视频"按钮,拉起相册模态界面。

- 选择至少2张图片并点击 “确定”,系统开始合成视频,并显示加载弹窗。

- 视频合成完成后,加载弹窗消失,视频自动播放。

具体实现

UI层

- 使用PhotoViewPicker从图库中选择图片,当选择数量少于2个时,toast提示数量至少2个。

- 遍历处理图片,使用createImageSource解码图片文件,使用imageSource.createPixelMap获取解码后的PixelMap,使用pixelMap.readPixelsToBuffer获取图片数据。

- 将pixelMap保存至C侧的队列中。

Native层

- C侧输入线程从PixelMap队列中取出待编码数据,拷贝到编码器输入队列中。

- C侧输出线程从编码器输出队列中取出已编码的数据送入封装器。

- 所有图片处理完成时,停止编码器和封装器。

- 在编码输出线程中,将输出队列的bufferInfo进行出栈,并将对应的数据通过封装器写入到视频文件中。

UI层

- 使用video组件播放视频。

- 使用saveButton,将视频保存至图库。

更多关于HarmonyOS鸿蒙Next中封装JPEG图片为MP4文件有原生库吗?还是需要调用C语言代码的实战系列教程也可以访问 https://www.itying.com/category-93-b0.html

具体实现

UI层

使用PhotoViewPicker从图库中选择图片,当选择数量少于2个时,toast提示数量至少2个。

遍历处理图片,使用createImageSource解码图片文件,使用imageSource.createPixelMap获取解码后的PixelMap,使用pixelMap.readPixelsToBuffer获取图片数据。

将pixelMap保存至C侧的队列中。

Native层

C侧输入线程从PixelMap队列中取出待编码数据,拷贝到编码器输入队列中。

C侧输出线程从编码器输出队列中取出已编码的数据送入封装器。

所有图片处理完成时,停止编码器和封装器。

在编码输出线程中,将输出队列的bufferInfo进行出栈,并将对应的数据通过封装器写入到视频文件中。

UI层

使用video组件播放视频。

使用saveButton,将视频保存至图库。

HarmonyOS Next中封装JPEG图片为MP4文件,目前没有公开的原生ArkTS/ArkUI库直接支持。官方媒体框架主要面向音视频播放、录制和基础处理。

实现此功能通常需要借助原生能力。在HarmonyOS中,可通过NAPI机制调用C/C++编写的原生代码库,或使用FFmpeg等第三方C库进行封装处理。

在HarmonyOS Next中,目前没有直接封装JPEG图片为MP4文件的单一原生库。你需要组合使用多个ArkUI/ArkTS API来实现这个功能。

核心方案是通过媒体编解码服务和媒体封装服务来完成:

- 图片解码:使用

image模块的createImageSource()和createPixelMap()将JPEG解码为像素数据 - 视频编码:使用

@ohos.multimedia.media的VideoEncoder将像素数据编码为H.264/H.265帧 - 封装处理:使用

AVMuxer将编码后的视频帧封装为MP4容器格式

关键代码结构示例:

import { media } from '@ohos.multimedia.media';

import { image } from '@ohos.multimedia.image';

// 1. 创建VideoEncoder

let videoEncoder = await media.createVideoEncoder();

// 2. 配置编码参数(设置帧率、关键帧间隔等)

let encoderConfig = {

width: 1920,

height: 1080,

bitrate: 2000000,

frameRate: 30,

codec: media.CodecMimeType.VIDEO_AVC

};

// 3. 创建AVMuxer并添加视频轨道

let muxer = await media.createAVMuxer();

let trackIndex = await muxer.addTrack(media.TrackType.VIDEO, encoderConfig);

// 4. 循环处理每张JPEG图片

for (let jpegData of jpegImages) {

// 解码JPEG为PixelMap

let imageSource = image.createImageSource(jpegData);

let pixelMap = await imageSource.createPixelMap();

// 编码为视频帧

let frame = await videoEncoder.encodeFrame(pixelMap);

// 封装到MP4

await muxer.writeFrame(trackIndex, frame);

}

// 5. 完成封装

await muxer.stop();

注意事项:

- 需要处理时间戳同步,确保视频播放的连续性

- 考虑内存管理,及时释放解码后的像素数据

- 配置合适的编码参数以平衡文件大小和视频质量

这个方案完全基于ArkTS/ArkUI原生API,不需要调用C语言代码。如果需要更高级的控制(如自定义编码参数、复杂的时间轴管理),可以结合使用@ohos.multimedia.media中的底层接口。